2023第45卷第7期

“请大数据把这条推给需要双十一攻略的姐妹!”这是一条购物分享帖子的标题。网友们用自己的方式调试着互联网算法,以满足自身对信息的需求。算法已然嵌入日常生活,虽然不是每个人都是算法工程师,但每个普通用户都会对算法这一神秘概念有自己的朴素理解,并以此与算法互动。这种人们对算法的感知、想象和体验,以及这种想象带来的社会现实,被Bucher(2017)定义为算法想象(algorithmic imaginary)。虽然后续研究在不断完善这个概念的具体含义,但Bucher(2017)首次提出的这一概念展现了巨大的学术想象力,她给予了人文社科学者一个重要的研究算法和理解算法的视角,指出了算法不仅是一个技术概念,还是一个文化概念。人类用户对算法运作机制和强大功能的想象,使他们在人机交互中不断产生期望,并影响他们使用算法的方式(Burton等,2020);他们使用算法的方式,又会影响到算法的社会后果。理解人与算法相遇的空间,不应仅仅只是窥探“黑箱”内部的代码问题,更应该深入了解算法与人类之间的连接过程。

算法首先是一个技术概念,是指导计算机执行特定任务的一系列机器可读指令(Knuth,1998)。作为在线网络平台架构的重要组成部分,它可以自动过滤大量信息,并向用户提供个性化的定制内容、服务和广告(Van Dijck等,2018)。在实践中,算法被广泛应用于各种在线情境,例如网络购物(京东、淘宝等)、内容娱乐(抖音、小红书等)、在线社交(微博、Soul等)、互联网广告(今日头条等)等。

同时,算法也是当下社会科学难以忽略的重要议题。宏观上,由大数据驱动的算法成为社会中新的权力掮客,构建和实施权力知识制度,并不断重塑人、物体与各种系统之间的互动(张萌,2022)。这部分研究更偏向于后现代主义的批判路径,不是本文关注的重点。

本研究更关注具有能动性的个体与算法之间的互动博弈,以及算法想象在其中扮演的角色与作用机制。这也是目前关于算法影响与人机互动研究的重要热点之一。该方向的研究近年来一直在剧增,Web of Science核心数据库中已经有两万余篇相关文章,传播学、心理学、人类学、社会学等多个学科领域的国际顶级期刊如Communication Research、Frontiers in Psychology、Big Data & Society、Social Media+Society上均刊发了不少相关文章,都在探讨“算法–用户”关系中用户对算法本质及功能的想象,以及想象关联的一系列活动,这是一个极具潜力、辐射学科较广但国内探讨较为有限的领域。因此,本文基于想象可供性视角来统合现有的散布在多个学科的相关文献,力图对“算法想象”这一目前较为模糊的概念及其研究进行梳理,提供一个更加完整和清晰的图景。

因此,本研究试图通过想象可供性框架,厘清算法想象的以下三个问题:(1)如何理解人机互动中的算法想象?(2)用户是如何形成算法想象的?(3)算法想象在社交媒体实践中如何体现。

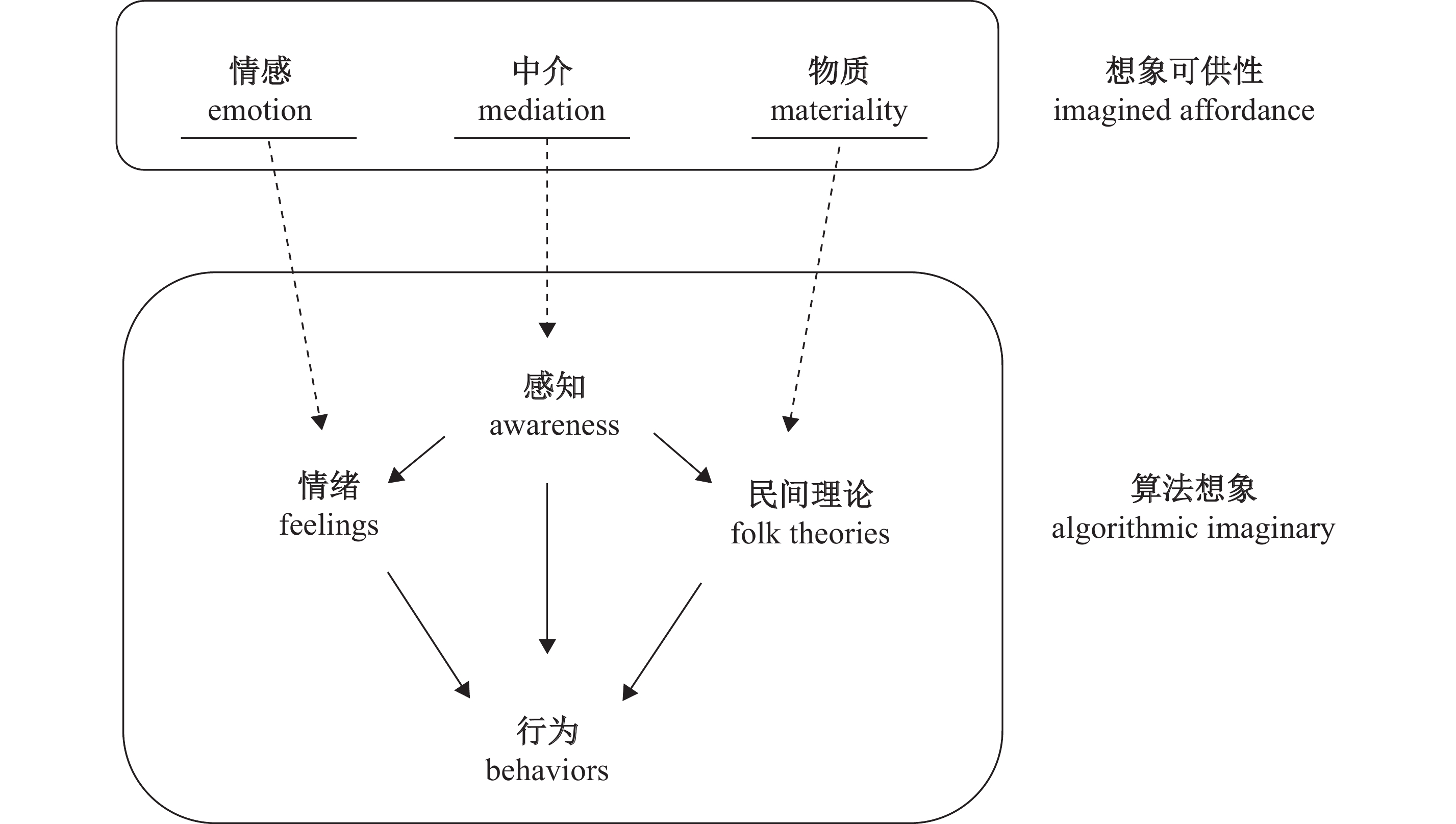

为了更好地回应以上问题,并推动算法认知与行为的理论研究,本文将系统梳理现有的算法想象相关文献,首先对算法想象的内涵及已有的测量方法等进行归纳;其次,在想象可供性理论的支持下对算法想象概念进行拓展,细分现有的研究脉络,构建算法想象整体链路(如图1所示);最后,从数字鸿沟、算法与企业应用、中国情境下的算法交互等方面对未来研究进行展望。算法系统日益嵌入社会生活,本文从理论上为厘清个体的能动性如何影响数字社交媒体平台景观提供了可能的解释路径,从实践上为公众技术接纳和算法教育提供了参考。

|

| 资料来源:作者根据相关文献整理。 图 1 想象可供性视角下的算法想象 |

(一)算法想象的定义

算法“不可见”并不意味着算法“不可感知”。对于多数用户来说,算法代码的具体运作是一个“黑箱”,难以窥探(Burton等,2020;Hargittai等,2020)。但“黑箱”不意味着用户无法感知算法。在心理学中,想象作为不完全理性但对理性至关重要的概念,持续影响人们如何感知环境,并可能调节人们的偏好(Batliner,1993)。用户可以通过过往经验和设想,来影响算法“黑箱”。既然算法对人类用户而言并非“不可知的”,那么我们如何去描述用户这种自适应的、普遍的和无处不在的感知以及遭遇算法时发挥自身能动性展开的互动性实践?

Bucher(2017)关注到了这一现象并进一步提出了“算法想象”概念。她将算法想象定义为人们对算法的感知、想象和体验,以及这种想象带来的社会现实。在她的质性研究中,针对Facebook用户的访谈表明,算法想象远不是一种虚幻的关系,用户体验算法的地点和情境塑造了人们对算法的感知、思考和讨论算法的方式。

后续越来越多的学者意识到算法系统并不能单方面决定用户的行为,用户如何理解、感受算法并参与算法实践成为重要的研究命题。在算法想象概念之外,诸如“民间理论”(folk theory)、算法抵抗(algorithmic resisitance)、算法八卦(algorithmic gossip)、可见性游戏(visibility game)等类似或关联性概念的提出及相关实证研究丰富了以用户为中心的算法互动性实践研究(Gelman和Legare,2011;DeVito等,2018;Bishop,2019;Cotter,2019;Velkova和Kaun,2021)。事实上,针对其他平台的研究中也有算法想象的身影。后续众多研究也将视野拓展到了Twitter、YouTube、Instagram、抖音等等涉及不同“算法–用户”连接方式的社交媒体平台(Bishop,2019;Cotter,2019)。

然而,目前这些研究大部分仅从微观层面说明了用户与算法在某一平台的纠缠,或者是同一反应过程中的不同阶段,停留在某一时刻的横截面研究或某一特定群体的局部研究,对用户复杂的知行过程缺乏整体性描述。

目前的算法想象概念并不能完全描述实践中的“想象图景”。第一,Bucher(2017)所提出的算法想象概念是单个用户对算法系统和社交媒体平台的想象,但用户可能会在群体或公共平台上分享个人对算法的想象,形成对于算法的集体“知识”共享和公共策略,这种策略甚至可能会随着算法的改变而不断迭代,当前的算法想象概念只关注到了技术(如按钮、屏幕设计、操作系统等),而没有指出现实数字环境中他人/社会观念的影响;第二,Bucher(2017)的定义所描述的“人们对算法的体验”解释并不严密,实际上这表现为人们与算法相关的感受、情绪、情感以及行为,该定义也并没有指出知觉、情感等对用户后续算法行为的影响。

因此,本文试图从想象可供性的视角切入,进一步完善和明确算法想象这一概念。

(二)想象可供性视角的引入

在对技术、媒介与主体之间关系的研究中,可供性(affordance)概念在传播学界逐渐得到认可。Gibson(1986)最早界定了该概念,认为它是客观、真实和物理的,不会因观察者需求的变化而改变。Norman(1999)将该概念引入设计领域,提出了感知可供性观点,认为可以通过设计特定的物体来鼓励或限制某些行动,建议设计师“指示用户如何与设备互动”。Gaver(1996)认为可供性不仅存在于个人行为中,也存在于社会互动中,并将其理解为一种社会性的可见性。综合两种观点,Hutchby(2001)指出,可供性是处于技术决定论和技术建构论中间地带的第三条道路,一方面要考虑物质的约束和可能性,另一方面要考虑技术在社会建构方面的定位。

想象可供性(imagined affordance)则强调了主体对技术客体的想象作用及其发生的关键机制,包括用户的感知、期望和情感(Nagy和Neff,2015)。用户可能对现有的通信技术、数据和媒介有一定的期望,这些期望在实际和实践中塑造了他们使用这些技术的方式并启发他们的行动。想象可供性出现在用户的感知、态度和行为之间,在技术的物质性和功能性之间,以及工程师的意图和行动之间。在想象可供性的视角下,用户在中介、物质和情感方面能够发挥自身能动性,与算法协商互动的关系过程。

算法想象和想象可供性都强调了用户对算法的感知和情感体验,强调了想象在数字环境中的重要性,但二者也有所不同。算法想象是想象可供性在社交媒体平台上的一种呈现。可供性作为一种中观理论,将技术使用与我们在个人、团体和组织层面对其更广泛的理解联系起来,架起了抽象理论研究与具体经验分析之间的桥梁。用户的属性和能力、技术的物质性以及技术使用的情境都是潜在且动态变化的,想象可供性提供了一个框架,总体描述了用户与算法系统、设计者三者之间的互动关系。但算法想象则更聚焦于社交媒体平台及单向的想象过程的具体实践过程,并不包括其他主客体如社交媒体上商业链条上的平台设计者、供应商、品牌广告主等的想象。算法想象重点在于表明行动的可能性不能一劳永逸地确定,而需要以人们自己的感知和经验为基础(Bucher和Helmond,2017)。

社交媒体平台是一个特殊的社会–技术环境,吸引不同类型的用户并协调他们之间的关系。通过这个环境,我们能够观察到平台如何为不同的用户提供不同的内容,并了解他们是如何通过不同的行动可能性相互连接的。从想象可供性视角出发,可以揭示人类和算法在平台中的行动方式,并且通过算法想象这样一条充满可能性的感知—行动路径解释主体之间的互动与影响。

(三)想象可供性下的算法想象概念及其分析框架

想象可供性为算法想象概念的拓展提供了理论资源。当前的算法想象定义存在不足,缺乏用户依据外部世界经验整体形成的算法知识系统,并且未考虑知觉在行为决策中的重要作用,而这正是算法想象能够影响社会现实的手段。皇甫博媛(2021)论证了想象可供性框架在对算法想象进行解构和延展方面的潜力。想象可供性强调人与技术之间建构的或想象的交互本质,这意味着,技术属性不仅是实际存在的属性,也是用户想象出来的属性。可供性并不平等地呈现给每一个人,有些可供性只与某些群体相关,例如社交媒体博主会比普通用户更关注平台算法规则的变动,并花更多的时间研究如何获得最大的流量曝光(Duffy等,2017)。

基于想象可供性的关键特质,本文将算法想象的定义扩展到个体对算法系统的感知、情感,与其相关的民间理论以及算法行为。研究范围限于各类基于用户关系和大数据推荐算法技术来打造信息环境和实现内容交换的泛社交媒体平台。最终,算法想象不仅包括人们对算法建构的“心理模型”,还涵盖了这些想象具有的生产能力和情感能力,将人类的使用与数据、算法、平台连接起来,在复杂的交互过程中锚定想象的能动性。

最初的算法想象概念并不具有严密的定义,本文希望进一步明确算法想象的组成,并将算法想象解构为算法感知、算法情绪、算法民间理论以及相关的算法行为(如表1)。想象可供性的中介、情感、物质三个关键特质,一一对应地分析算法想象中的实践(如图1)。中介体现为用户数字设备与算法共同形成的中介数字空间,借助中介,用户才能感知到这一虚拟空间的内核以及算法的隐匿性。情感则表现为用户在中介空间中产生的瞬时情绪,还有面对算法长期积累成的感情,是影响用户态度及体验的重要因素。物质则表现为数字设备及算法的客观存在与用户赋予的社会意义的结合,用户对其功能的使用并不一定按照其设计者所设想的轨道,而是依据用户自身对算法系统的总体理解,也就是所谓的民间理论。

| 概念 | 含义 | 来源 |

| 算法想象(原始) | 人们对算法的感知、想象和体验,以及这种想象带来的社会现实 | Bucher(2017) |

| 算法感知 | 人们在多大程度上意识到算法在在线空间中的存在 | Eslami等(2016) |

| 算法情绪 | 算法帮助暗示生成的无形情绪、情感和价值观 | Bucher(2017) |

| 算法民间理论 | 个体发展来解释技术系统的产出、影响或结果的

直觉的、非正式的理论 |

DeVito等(2017) |

| 算法想象(拓展) | 个体对算法系统的感知、情绪,与其相关的民间理论以及算法行为 | 本文 |

| 资料来源:根据相关文献整理。 | ||

而在算法想象链路的内部(如图1),由于平台的功能只有在用户知道该功能可用时才支持访问,因此感知是算法想象的先决条件和基础,突出用户的主观性。在感知到算法的存在后,用户可能会对算法所提供的服务抱有迥异的态度,并由此产生不同的情绪,生成复杂的情感,进而影响到后续的行为表现。用户也有可能根据自身的经验以及外部的知识,总结出对平台算法运行的个体解释,形成算法民间理论,并据此完成在平台上的行动。需要强调的是,现有研究并没有显示情绪(情感)与算法民间理论的形成存在必然联系,二者更多的是分别从感性和理性路径影响用户的行动可能性。

综上,感知、情绪和民间理论在主体内部相互影响,最终集体作用于多样化的算法行为,形成算法想象的整体链路。虽然这几个细分概念在分析上是独立的,但它们在实践中不可分割。接下来,本文将按照这一分析框架,对现有研究的成果进行评述,回顾以用户视角为中心的实证研究。

三、用户主体与算法想象:细分维度与互动机制(一)算法感知:作为中介的算法环境

虽然互联网空间通常具有响应性或适应性,但用户经常将这一虚拟中介环境视为稳定不变的。Nagy和Neff(2015)指出用户在有效使用中介环境之前,需要在文化、社会等方面认知它,否则其适应和修改系统的能力有可能会被其自身的认知所限制。想象可供性视角下的算法想象则可以帮助用户对算法的挑战做出反应,而算法感知则是算法想象存在的必要条件。

算法感知(algorithmic awareness)是指人们在多大程度上意识到算法在在线空间中的存在。过往研究用户与算法系统交互的学者普遍认为用户对算法的感知和关于算法的知识是使用互联网的元技能和获得其他额外技能的先决条件(DeVito,2021;Dogruel等,2022b;Shin等,2022;Zarouali等,2021)。用户对算法的感知有助于人们客观地看待算法及其提供的服务,在决策中保持自主权,谨慎地与算法互动。对算法的感知可以解构为以下四层:

第一层,用户对算法的存在感知。当下互联网用户可能并没有意识到他们已经被个性化内容环绕。多位学者使用访谈法询问了用户关于算法的直观感知,如Eslami等(2016)对Facebook用户关于内容管理算法的调查发现,超过一半的人不知道它的存在;用户无法识别新闻消费领域中的算法操作,甚至大多数用户并不知道搜索引擎中输出的内容是否是个性化的(Eslami等,2016;Dogruel,2021)。另一项针对算法感知的大规模问卷调查发现,即使在挪威这种高度数字化的发达国家,依然有62%的受访者认为他们对算法的认识匮乏(Gran等,2021)。

第二层,对算法的自动化决策感知。目前的研究还关注到在社交/购物/新闻/语音助手等特定服务中发挥作用的推荐算法和自动决策服务,多数用户只认识到算法的广泛影响,只有小部分用户能够意识到算法正在通过自然语言处理或情感分析技术,自动提取信息来进行相关推荐(Alvarado等,2020;Gruber等,2021)。这意味着算法正在逐渐取代人类专家和过往建立的制度规范,为人类决策提供建议。

第三层,对人与算法互动过程的感知。用户理解平台对内容的呈现不仅是特定算法逻辑的结果,也是与外在环境交互的结果。就算法平台上经验丰富的用户而言,他们普遍非常清楚在各种网站上的个人–算法互动(如点赞、评论和阅读)会影响后续的内容推送管理,他们甚至会通过改变行为,不断重塑算法结果(Eslami等,2016;Bucher,2017;Eiband等,2019;皇甫博媛,2021)。

第四层,对算法运行过程中潜在伦理问题的感知。首先,算法需要收集和储存大量的个人数据来保证个性化内容的推送,这可能会带来对用户隐私的威胁,如未经允许的追踪、数据泄露、数据倒卖等(French和Hancock,2017)。其次,用户很难理解缺乏可感知透明度的平台系统,导致对平台的不信任和盲目信任两种极端情况(Shin,2022)。虽然具有伦理考量意识的用户只占少数,但他们对算法的感知更敏锐,也多持负面态度,甚至有可能拒绝接入算法(Dogruel等,2022a;Gran等,2021)。

以上四个部分说明了不同层面的算法意识。由于地域文化、经济水平、数字化程度以及自身素质等因素的影响,用户所产生的感知存在差异。关于对算法感知和意识的测量,以上研究多采用定性访谈以及自我报告的方式,这虽然提供了一个可行的起点和深入理解用户思想的机会,但必然缺乏普适性,也难以大规模地了解用户意识。近年来一些研究已经开始尝试标准化度量算法意识,Dogruel等(2022b)和Zarouali等(2021)分别开发出了算法素养量表和算法媒体内容感知量表,从多个维度衡量用户对算法的感知,并在不同的算法平台上进行了测试。

感知是算法想象的第一步,对算法的感知决定了用户在多大程度上有能力形成对算法的整体信念,并生成应对算法使用和变化的行为理论。

(二)算法情绪:作为感情载体的算法技术

用户的情绪状态(feelings)和情感(emotion)很大程度上会影响人与技术的互动,数字产品和设备的功能设计和审美可能会唤起用户的某些情绪(Nagy和Neff,2015)。想象可供性将它们整合到了对传播领域可供性的思考中。具体来说,用户可能会将某些情绪或情感内容投射到技术上,将其视为“关系实体”或者“社会行动者”,在此基础上与技术进行互动,甚至无意识地认为技术本身就是社会存在。Bucher(2017)也认为,在与算法相遇时,人们体验到的并不是算法本身,而是算法帮助暗示生成的无形情绪、情感和价值观。对人机互动过程中的非理性思维过程和情感影响进行研究能帮助我们更清晰地理解该过程的复杂本质。

实践发现,算法本身所具备的某些功能和设计,可能会成为用户的“情感线索”。个人化的、特定的嵌入情景影响着用户对算法的情感态度(皇甫博媛,2021)。Lee(2018)通过实验发现,对于算法决策,当人们认为算法可以作为工具帮助完成工作时,他们的情绪会得到积极的提升。但如果员工觉得自己正在被算法监视着工作,他们可能会对算法产生极大的不满。还有多位学者在研究中提及用户由于算法准确或错误推荐而产生的情绪后果,例如因为刷到偶像最新抖音视频而开心的粉丝,以及由于算法将去世家人的照片作为年度回顾而悲伤的父亲等(Bucher,2017;DeVito等,2017;Parisi和Comunello,2019;Eiband等,2019;皇甫博媛,2021)。

此外,人与算法之间的情感影响也并不是单向的,情感识别算法成为这一传递渠道。情感识别算法使用社交媒体行为、流媒体服务、语音、面部表情和生物特征等数据源来识别、推断和捕捉情感。谷歌、亚马逊、Facebook等平台已经将情感识别技术运用到了现实算法环境中。Hilbert等(2018)通过实验室实验和语义分析的方法,用转移熵量化了从用户到推荐算法以及从推荐算法到用户情绪所涉及的信息流,研究结果证明了交互过程中情感信息的转移,推荐算法对用户的初始情绪做出了响应。以搜索选择关键词和观看偏好的形式传递给算法的人类情绪,反过来又向人类用户传达了显著的积极(快乐)和消极(厌恶、悲伤)影响。但目前用户对算法情感识别的态度是复杂的,有研究显示人们并不信任情感识别算法将情绪视为洞察行为的窗口,认为情绪识别容易导致用户被算法操纵,丧失自主权和控制权(Andalibi和Buss,2020)。

许多学者对算法信任(algorithmic trust)进行了讨论。信任通常是情感及理性思考之混合体,算法信任可以作为人们对技术的使用态度和行为意向的预测因子,如基于理性思考的认知信任和情绪化的情感信任,积极采纳算法建议的算法欣赏态度和拒绝算法推荐的算法厌恶等(Logg等,2019;Lee,2018;Araujo等,2020;Glikson和Woolley,2020)。还有学者提出了算法源可信度(credibility of algorithmic sources)以及算法信念(algorithmic belief)概念,分别指代用户对算法作为传播渠道的感知可信度和用户对算法合法性的信念,并用来解释算法介导的传播效果以及人们对算法所提供的服务的认可和接纳的程度(Sharabi,2021;Shin,2021)。

算法信任显著影响人们对算法的态度。用户在对算法的感知和行动之间所经历的信任建立过程虽然仍在探讨中,但已被证实与FATE框架(即公平性、透明度、可问责性、可解释性)密切相关(Ferrario等,2020;Glikson和Woolley,2020;Shin,2021,2022)。FATE既有算法系统的原生属性,也与人们对算法的理解和参与有关。研究发现,当用户意识到算法对自己的准确评估时,他们会变得更加敏感和警惕。用户对公平性、透明度、可问责性的感知和评估正向影响他们对算法的满意度,信任在公平性、透明度、可问责性对满意度的影响中发挥着调节作用(Shin,2021)。公平性突出了人们对算法公正、无偏见和无歧视的要求,可问责性则强调了对算法服务结果的责任归因。透明度和可解释性有助于用户建立最接近算法真实运作方式的民间理论,这意味着在技术上向用户开放,说明算法工作的方式,即使用户无法理解技术细节,也应该建构语境,以便用户消除疑虑,有效建立好感。

(三)算法民间理论:想象中的算法属性

人们为什么用技术做这件事情,人们为什么认为技术能做到这件事情?这与技术的物质性息息相关。Leonardi和Barley(2008)认为物质性可以理解为某种理论观念的实例,以及特定背景下的意义。Nagy和Neff(2015)指出技术的物质性一定程度上是由其社会性决定的。物质性可以界定为实现某种观念的物质基础或属性,以及相关的意义(皇甫博媛,2021)。用户对算法原理的理解和想象,以及对算法技术界面的使用和参与共同构成了想象可供性的“物质性”维度。算法的使用方式具有明显的物质性。例如,抖音用户普遍认为抖音的“个性化”推荐是由关注、点赞、搜索历史、播放时长等决定的,因此在看到自己喜欢的视频时,他们会积极点赞评论,期望抖音的推荐反馈机制能够推荐更多同类内容。

这种用户自发产生的对因果关系的解释,又被称为民间理论(Gelman和Legare,2011)。在算法和人机交互领域,民间理论可以定义为个体发展来解释技术系统的产出、影响或结果的直觉的、非正式的理论(DeVito等,2017)。

算法民间理论是算法想象的具体呈现。首先,用户的算法理解不是精确的理论模型,而是一种关于系统的隐含信念的集合,民间理论的直觉性与“想象”吻合。其次,民间理论不仅可以解释系统工作逻辑,也描述了算法背后的企业及其文化如何影响整个网络社会,代表了对系统的整体思考。最后,民间理论并不认为用户持有错误的、需要纠正的理论,而是强调用户凭直觉、日常经验所持有的非正式理论有其合理性,并且是动态变化、易于发展的(French和Hancock,2017)。算法民间理论与用户对算法的感知、态度和情感相关联,共同构成“想象的图景”。

当前关于算法民间理论有两种研究取向。一种研究取向是将民间理论作为一种检验受众意识的方法,关注用户理解算法、平台等概念的程度,以及他们如何处理与算法相关的问题,并将其具体化为详细的理论。另一种研究取向的重点不是民间理论本身,而是探索用户形成这些民间理论的过程以及影响因素。

1.算法民间理论的研究现状

算法民间理论作为用户在重复的日常经验和自我观察下形成的产物,反映了用户对算法和平台的看法,用户的这些理解形成了多种民间理论,并涉及不同的社交平台和软件应用(见表2)。由于差异化的理解水平和复杂的认知方向,用户可能同时持有一种或多种民间理论(Liao和Tyson,2021)。

| 平台 | 算法民间理论 | 主要内容 | 文献来源 |

| 1.个人参与理论 | 与好友的互动数量会显著影响社交平台的内容过滤 | Eslami等(2016) | |

| 2.格式理论 | 某些特定类型的内容(如视频)更有可能被平台推荐 | ||

| 3.控制面板理论 | 使用控制设置(如屏蔽、取消关注)会显著影响社交平台的内容过滤 | ||

| 4.吵闹或安静的朋友理论 | 更频繁发帖的用户更有可能被算法系统过滤掉,以呈现内容协调的信息环境 | ||

| 5.上帝之眼理论 | 用户认为平台试图避免传播政治和宗教内容,并对这些内容进行过滤 | ||

| 6.水仙理论 | 与好友的相似程度会影响用户看到这些朋友发布的内容的数量 | ||

| 7.原创理论 | 原创的内容更不容易被过滤,从而出现在他人的视野中 | ||

| 8.全球流行理论 | 他人的点赞和评论的数量显著影响内容呈现的可能性 | ||

| 9.新鲜血液理论 | 新朋友发布的信息更容易被看到 | ||

| 10.随机理论 | 算法可能只是随机选择了某些帖子 | ||

| 1.操作理论 | 缺乏对算法工作的详细理解,但认为算法会根据某些标准做出决策,如内容流行度、广告优先级等 | DeVito等(2017) | |

| 2.抽象理论 | 不包括理论化算法如何实际操作的具体尝试,它像一个模糊的“他者”,广泛描述算法的影响 | ||

| Facebook和Twitter | 1.理性助手 | 对算法持有积极评价,认为算法理解并优先考虑他们的兴趣 | French等(2017) |

| 2.透明平台 | 对算法持有积极评价,并相信内容是未经过滤的 | ||

| 3.多余的观察者 | 对算法持有负面评价,并认为公司过度使用个人数据来创造利益 | ||

| 4.企业黑箱 | 算法底层逻辑不透明,难以控制,并服务于公司利益 | ||

| Crysral Knows | 1.数据源:单一来源与聚合来源 | 关于算法所使用的数据来源,用户认为是来自一个平台还是多个平台 | Liao等(2021) |

| 2.数据范围:快照理论与时间轴理论 | 关于算法处理的数据范围,用户认为是基于当下的信息披露还是长期的信息收集 | ||

| 3.收集程序:设置保护理论与加权个性化理论 | 关于算法的运作方式,用户认为是从已设置为公开的社交媒体平台提取数据,还是访问所有平台,并加权来自人格特征最活跃的平台的数据 | ||

| 4.个性化输出:占星术与全知 | 关于算法的个性化准确性,用户认为算法是在一般人格特质上进行调整,还是算法具有全知能力,强大到可以实现高度个性化 | ||

| 资料来源:作者根据相关文献整理。 | |||

目前大多数研究主要集中在用户对特定平台服务的看法上,Dogruel(2021)提供了一个更广泛、更普遍的互联网用户关于在线算法系统的民间理论,细分发展出五种具体的民间理论。第一,经济取向理论。建立在用户对互联网公司利润导向的认知上,谷歌等平台会收集用户的年龄和性别、购物历史和国籍等信息,以创建个人资料库,向目标消费者提供定向广告(Dogruel,2021;Liao和Tyson,2021)。第二,个人互动理论。用户认为他们在各种网站上的个人互动(例如,点赞、评论或阅读时长等)为算法提供了信息,并影响到了他们的信息推送内容。第三,流行理论。大多数受访者认为算法的输出是个人偏好和众多用户普遍偏好的综合反映。第四,分类理论。用户认为算法收集了广泛的生活数据,包括面对面谈话和手机中储存的信息,并据此将用户划分为特定类别,据此提供差异化的信息(Bucher,2017;Cotter,2019;Siles等,2020;Dogruel,2021)。第五,算法思想理论。用户倾向于把算法想象成类人的存在,它们会监视个体活动,甚至进行跨平台数据交流。

整体来说,这五种民间理论基本概括了先前特定平台研究中的算法民间理论观点,并通过实证研究证实了它们在德国互联网用户中的普遍性,适用性更广,进一步扩展了关于算法系统工作的民间理论认知蓝图(Dogruel,2021)。

2.算法民间理论的形成过程与影响因素

民间理论是文化惯例和实践的一部分,个体可以通过它获得相应的文化能力,如自我呈现、获得群体归属、维持现有的社会关系等(Siles等,2020)。算法民间理论的形成过程通常分为三步,分别是信息收集、理论建构、多方确认。当面对一个不熟悉的算法系统时,人们会自发地寻找信息指导行动,并将多个来源的信息聚合成一个“知识理论”,即民间理论(DeVito等,2018)。这些民间理论往往是由不同的具有因果关系的信息碎片勾起,凭直觉形成的,因此相对来说不够严密和准确。当民间理论成型时,用户会通过对平台的观察和操作对其进行验证,甚至在群体或网络中进行分享和交流,寻求认同和改进(Cotter,2019)。

关于受众会持有哪种算法民间理论,用户的使用目标、信息来源、数字素养发挥着关键作用。用户支持某一特定理论最普遍的原因之一是用户的使用目标。对于内容消费者与普通用户而言,最常见的目标是自我呈现与娱乐,因此他们更倾向于持有个人互动理论和流行理论,认为算法推荐结果是一种自我表现的方式,会显示个人身份和品位(Siles等,2020)。网络意见领袖们的目标是可见性奖励,他们通常对算法及其背后的公司持有更为理性客观的态度,并将民间理论作为一个可塑的工具用于生产(DeVito,2021)。完全依赖内源性信息聚合民间理论的参与者有更强的算法理解能力和信息搜集能力,具备高数字素养,他们所持有的民间理论细节更为丰富,也更贴近实际的算法运作模式(DeVito等,2018)。

(四)算法想象下的个体行为

算法想象帮助人们在日常生活中对算法做出反应。是否拥有算法感知意识是形成算法想象的先决条件。在算法已成为数字基础设施的情况下,了解塑造网络的结构性力量不仅可以获取一种互联网知识,也是个体作为一位现代公民管理信息的必要技能。在算法自动决策领域和新闻信息领域,缺乏算法感知意识可能会导致比互联网技能水平差异造成的数字红利差异更严重的后果。当新闻推荐系统生成包含错误或诽谤信息的新闻时,有能力质疑数据来源以及隐私安全的用户和“不知情”的人之间将再次产生新的“鸿沟”,对公民个人信息财产安全和社会民主参与都构成威胁。

算法信念水平直接影响用户面对算法时的行为。当用户缺乏基本的算法信任时,对算法推荐内容甚至算法本身都有可能持负面态度(Shin,2022)。但当用户认为算法有能力提供高质量反馈时,他们更有可能允许个人数据被收集,依据算法做出决策。在线约会领域提供了一个独特的机会来研究算法信念。在线约会软件与普通社交媒体不同,它强调面向公众,致力于让用户相信他们可以通过算法在平台上找到匹配的另一半。纵向调查发现,相信匹配算法的人会向伴侣进行更多自我披露。在首次约会中,使用算法选择伴侣的人与依靠自己选择伴侣的人一样成功(Sharabi,2021)。关于情感感知系统的研究也发现,面对同样的生理数据,不同算法框架下的参与者报告了迥异的情绪和测试体验,并都倾向于相信算法的准确性。当算法系统“虚假”呈现为检测到升高的“压力”时,参与者有更多的焦虑自我报告和身体症状出现,而积极框架和对照组并没有受到同样的负面影响(Hollis等,2018)。这意味着算法信念独立发挥作用。即使算法并不“真实”“有效”,只要人们坚定地认为算法机制可信任,算法就仍然可以产生积极的结果(Parisi和Comunello,2019)。

差异化算法民间理论下的用户在与算法互动的过程中的能动性发挥呈现出两面性。一方面体现为积极配合算法结构性规则。DeVito(2021)将这种积极用户称为深入研究算法细节的结构理论家,他们会更主动地适应算法变化,调整现有的自我表现策略,重新确定内容的优先级。Cotter(2019)将认同“建立密切的联系将获得算法的奖励”一类民间理论的社交媒体名人命名为“关系型网红”,他们通过回复评论等策略,踊跃与粉丝交流,迎合算法来获得更多的流量曝光。

能动性另一方面体现为对算法规则的“抵抗”、对算法功能的“挪用”以及对算法结果的“改写”与“颠覆”,例如对算法产品的隔绝、对算法规则的自我重组、对算法逻辑的反向规训与控制等(Siles等,2020;Magalhães,2022;陈阳和吕行,2022)。在对抗算法的力量时,用户有可能会选择取消标记内容、清空过往创作、暂时脱离特定平台、停用或删除账户等方式,也有可能通过反向屏蔽故意“愚弄算法”,甚至通过与传统媒体力量合作、组织社会运动团体、自研数字空间等应对算法的“偏见”(Cotter,2019;Velkova和Kaun,2021;Magalhães,2022;Xie等,2022)。

四、贡献、启示与未来研究方向(一)理论贡献

本文的理论贡献有以下两点:第一,建立了想象可供性与算法想象之间的连接。Bucher(2017)所提出的算法想象概念是从小样本的用户访谈中归纳出的,其定义比较模糊,不够严密,也很难进一步操作化(Bucher,2017)。想象可供性与算法想象概念契合度颇高,借助想象可供性的特质有助于厘清算法想象概念,进一步搭建算法想象的研究框架。

第二,本文开创性地拓展了算法想象的概念边界,指出了算法想象在“算法–用户”关系中的关键作用。算法作为近年来炙手可热的科技动力,推动了诸多领域的快速发展,但看到算法强大之处的同时,我们也必须避免将算法过度“神话”。不论是人们对算法系统的理解还是算法系统本身,都处于不断建构、协商、情景化和不同的解释过程中。目前社交媒体平台中的人与算法关系研究仍未达到成熟阶段,还有较大的探索空间。我们统合现有的算法相关研究,以个体的感知、情绪、民间理论以及行为表现这一算法想象完整链路,厘清个体的能动性影响当下数字社交媒体平台景观的可能机制,为后续研究提供了参考。

(二)实践启示

本文在公众技术接纳和算法教育两方面对社会管理实践具有重要的参考意义。

首先,从技术接纳的角度来看,算法想象真实影响到了人们对技术的接纳意愿和使用方式。例如,搭载高级算法系统的人工智能聊天机器人ChatGPT的发布,引起了全球关于算法技术究竟是社会进步的助力还是威胁人类生存的危险因素的广泛讨论。赋予ChatGPT人格和情感,将它想象为类人存在进行交互,还是将其看作一个提供特定服务的工具进行使用,不同的使用路径显示了人们对技术截然不同的态度。因此,在组织引入算法系统辅助工作时,应当及时了解组织成员对算法系统的态度,并展开相关培训,提升员工对算法系统的了解和认可程度,实现人机合作的良性发展,进而推动工作效率的提升。另外,对于算法研发公司来说,算法想象也提供了用户视角的参考,意识到用户在平台中所具有的能动性后,研发公司可以多从科技积极方面与公众进行信息沟通,减少抵触心理。

其次,从算法教育的角度看,用户算法想象高度依赖于个人目标、数字素养和特定的嵌入场景。算法行业仍处于混沌状态,绝大部分人对互联网算法的运行和可能产生的结果依然没有整体的认知。这意味着,算法教育有必要作为现代教育的一环,由用户、算法公司、政府等各主体共同完成。用户应理性认识到算法程序化的本质和限制,以及自身在算法平台中所掌握的控制权,以此创造健康的信息环境,应对可能的算法错误和潜在的算法偏见。对于互联网公司来说,增加算法透明度并公开说明算法技术的运行方式应该成为企业的社会承诺,企业有责任提示用户使用相关技术会带来的后果。政府应意识到算法对社会的巨大变革仍在持续,并成为推动算法监管体系建设的重要力量。

(三)未来展望

总体上,未来的研究可以从以下四个方面展开:

1. 进一步关注算法所带来的数字不平等问题

现有研究表明,许多用户并不知道算法及其基本的运作规则,而持有复杂民间理论的用户却可以通过对“规则”的了解来获取数字红利(Cotter,2019)。这表明与数字鸿沟一样,算法有可能正在强化线下的社会特权等级。未来的研究可以进一步关注算法想象与现实中数字不平等之间的关系,例如如何从更多的维度全面地评估用户的算法想象和算法素养,比较互联网用户在不同文化、人口背景下甚至随时间变化的算法能力在应对算法带来的风险时如何发挥作用等。

2. 进一步关注可供性理论下算法想象的内在作用机制

算法想象的理论实践过程仍有探索空间。例如,现有研究集中在Facebook、Twitter、抖音等平台的算法之上,那么不同平台的机制以及价值观是否及如何影响民间理论的生成?网络意见领袖们如何在私域交流中迭代算法民间理论,他们与算法平台之间的关系未来会如何变化?如何更好地捕捉人们在算法空间中产生的情感?这些都可以成为未来的研究主题。

3. 进一步关注数字平台与算法想象之间的关系

算法想象在社交媒体之外的算法平台上是否适用?目前以算法平台为基础的数字劳动已经发展出相当庞大的产业链,从研发、运营到使用的过程都由技术与人类共同塑造。但拥有不同社会资本的用户或组织,对算法的影响力也有所不同,例如个体骑手难以撼动外卖平台算法,而大型餐饮商家提出的建议则有可能被平台采纳。那么,产业链中各级劳动者的算法想象差异会如何影响数字产业的实践与生态?算法平台日益嵌入社会架构中,人文关怀应该被铭刻进技术进化的核心逻辑中,未来的算法将如何平衡功能性、商业性与社会性?这些问题都还有待进一步探讨。

4. 进一步关注算法想象与人际关系的互动

目前关于算法及算法想象的研究集中在技术以及个体用户的想象链路中,但在中国,本土人情观念与作为技术的算法交织在一起。如美团外卖的派单虽然由算法控制,但站点管理者会根据和骑手的人情远近,在其能动范围内对派单进行一定的调整。这种人情关系和算法的交织还体现在骑手间的互助、餐厅优先出餐给相熟的骑手等方面,MCN机构也会因为人情关系而在其旗下网红主播的流量分配上有所倾斜

| [1] | 陈阳, 吕行. 控制的辩证法: 农村青少年的短视频平台推荐算法抵抗——基于“理性—非理性”双重中介路径的考察[J]. 新闻记者, 2022(7): 71–87. |

| [2] | 皇甫博媛. “算法崩溃”时分: 从可供性视角理解用户与算法的互动[J]. 新闻记者, 2021(4): 55–64. |

| [3] | 张萌. 从规训到控制: 算法社会的技术幽灵与底层战术[J]. 国际新闻界, 2022, 44(1): 156–173. |

| [4] | Alvarado O, Heuer H, Vanden Abeele V, et al. Middle-aged video consumers’ beliefs about algorithmic recommendations on YouTube[J]. Proceedings of the ACM on Human-Computer Interaction, 2020, 4(CSCW2): 121. |

| [5] | Andalibi N, Buss J. The human in emotion recognition on social media: Attitudes, outcomes, risks[A]. Proceedings of the CHI conference on human factors in computing systems[C]. Honolulu, USA: ACM, 2020. |

| [6] | Araujo T, Helberger N, Kruikemeier S, et al. In AI we trust? Perceptions about automated decision-making by artificial intelligence[J]. AI & SOCIETY, 2020, 35(3): 611–623. |

| [7] | Batliner A. Hearing and speech[J]. A Special Issue of the Quarterly Journal of Experimental Psychology-Section A-Human Experimental Psychology, 1993, 12(1): 55–56. |

| [8] | Bishop S. Managing visibility on YouTube through algorithmic gossip[J]. New Media & Society, 2019, 21(11-12): 2589–2606. |

| [9] | Bucher T. The algorithmic imaginary: Exploring the ordinary affects of Facebook algorithms[J]. Information, Communication & Society, 2017, 20(1): 30–44. |

| [10] | Bucher T, Helmond A. The Affordances of Social Media Platforms[A]. Burgess J, Marwick A, Poell T. The sage handbook of social media[C]. London: SAGE Publications, 2017. |

| [11] | Burton J W, Stein M K, Jensen T B. A systematic review of algorithm aversion in augmented decision making[J]. Journal of Behavioral Decision Making, 2020, 33(2): 220–239. |

| [12] | Cotter K. Playing the visibility game: How digital influencers and algorithms negotiate influence on Instagram[J]. New Media & Society, 2019, 21(4): 895–913. |

| [13] | DeVito M A. Adaptive folk theorization as a path to algorithmic literacy on changing platforms[J]. Proceedings of the ACM on Human-Computer Interaction, 2021, 5(CSCW2): 339. |

| [14] | DeVito M A, Birnholtz J, Hancock J T, et al. How people form folk theories of social media feeds and what it means for how we study self-presentation[A]. Proceedings of the 2018 CHI conference on human factors in computing systems[C]. Montreal, Canada: ACM, 2018. |

| [15] | DeVito M A, Gergle D, Birnholtz J. “Algorithms ruin everything”: #RIPTwitter, folk theories, and resistance to algorithmic change in social media[A]. Proceedings of the 2017 CHI conference on human factors in computing systems[C]. Denver, Colorado, USA: Association for Computing Machinery, 2017. |

| [16] | Dogruel L. Folk theories of algorithmic operations during Internet use: A mixed methods study[J]. The Information Society, 2021, 37(5): 287–298. |

| [17] | Dogruel L, Facciorusso D, Stark B. ‘I’m still the master of the machine. ‘Internet users’ awareness of algorithmic decision-making and their perception of its effect on their autonomy[J]. Information, Communication & Society, 2022a, 25(9): 1311–1332. |

| [18] | Dogruel L, Masur P, Joeckel S. Development and validation of an algorithm literacy scale for internet users[J]. Communication Methods and Measures, 2022b, 16(2): 115–133. |

| [19] | Duffy B E, Pruchniewska U, Scolere L. Platform-specific self-branding: Imagined affordances of the social media ecology[A]. Proceedings of the 8th international conference on social media & society[C]. Toronto, Canada: ACM, 2017. |

| [20] | Eiband M, Völkel S T, Buschek D, et al. When people and algorithms meet: User-reported problems in intelligent everyday applications[A]. Proceedings of the 24th international conference on intelligent user interfaces[C]. Marina del Rey, CA, USA: ACM, 2019. |

| [21] | Eslami M, Karahalios K, Sandvig C, et al. First I “like” it, then I hide it: Folk theories of social feeds[A]. Proceedings of the 2016 CHI conference on human factors in computing systems[C]. San Jose, CA: ACM, 2016. |

| [22] | Ferrario A, Loi M, Viganò E. In AI we trust incrementally: A multi-layer model of trust to analyze human-artificial intelligence interactions[J]. Philosophy & Technology, 2020, 33(3): 523–539. |

| [23] | French M, Hancock J T. What’s the folk theory? Reasoning about cyber-social systems[A]. Proceedings of the 67th annual conference of the international communication association[C]. San Diego, 2017. |

| [24] | Gaver W W. Situating action II: Affordances for interaction: The social is material for design[J]. Ecological Psychology, 1996, 8(2): 111–129. |

| [25] | Gelman S A, Legare C H. Concepts and folk theories[J]. Annual Review of Anthropology, 2011, 40: 379–398. |

| [26] | Gibson J J. The ecological approach to visual perception[M]. Psychology Press, 1986. |

| [27] | Glikson E, Woolley A W. Human trust in artificial intelligence: Review of empirical research[J]. Academy of Management Annals, 2020, 14(2): 627–660. |

| [28] | Gran A, Booth P, Bucher T. To be or not to be algorithm aware: A question of a new digital divide?[J]. Information, Communication & Society, 2021, 24(12): 1779–1796. |

| [29] | Gruber J, Hargittai E, Karaoglu G, et al. Algorithm awareness as an important internet skill: The case of voice assistants[J]. International Journal of Communication, 2021, 15: 1770–1788. |

| [30] | Hargittai E, Gruber J, Djukaric T, et al. Black box measures? How to study people’s algorithm skills[J]. Information, Communication & Society, 2020, 23(5): 764–775. |

| [31] | Hilbert M, Ahmed S, Cho J, et al. Communicating with algorithms: A transfer entropy analysis of emotions-based escapes from online echo chambers[J]. Communication Methods and Measures, 2018, 12(4): 260–275. |

| [32] | Hollis V, Pekurovsky A, Wu E, et al. On being told how we feel: How algorithmic sensor feedback influences emotion perception[J]. Proceedings of the ACM on Interactive, Mobile, Wearable and Ubiquitous Technologies, 2018, 2(3): 114. |

| [33] | Hutchby I. Technologies, texts and affordances[J]. Sociology, 2001, 35(2): 441–456. |

| [34] | Knuth D E. The art of computer programming: Sorting and searching (Vol. 3)[M]. 2nd ed. Redwood City: Addison-Wesley, 1998. |

| [35] | Lee M K. Understanding perception of algorithmic decisions: Fairness, trust, and emotion in response to algorithmic management[J]. Big Data & Society, 2018, 5(1), doi: 10.1177/2053951718756684. |

| [36] | Leonardi P M, Barley S R. Materiality and change: Challenges to building better theory about technology and organizing[J]. Information and Organization, 2008, 18(3): 159–176. |

| [37] | Liao T, Tyson O. “Crystal is creepy, but cool”: Mapping folk theories and responses to automated personality recognition algorithms[J]. Social Media + Society, 2021, 7(2), doi: 10.1177/20563051211010170. |

| [38] | Logg J A, Minson J A, Moore D A. Algorithm appreciation: People prefer algorithmic to human judgment[J]. Organizational Behavior and Human Decision Processes, 2019, 151: 90–103. |

| [39] | Magalhães J C. Algorithmic resistance as political disengagement[J]. Media International Australia, 2022, 183(1): 77–89. |

| [40] | Nagy P, Neff G. Imagined affordance: Reconstructing a keyword for communication theory[J]. Social Media + Society, 2015, 1(2), doi: 10.1177/2056305115603385. |

| [41] | Norman D A. Affordance, conventions, and design[J]. Interactions, 1999, 6(3): 38–43. |

| [42] | Parisi L, Comunello F. Dating in the time of “relational filter bubbles”: Exploring imaginaries, perceptions and tactics of Italian dating app users[J]. The Communication Review, 2019, 23(1): 66–89. |

| [43] | Sharabi L L. Exploring how beliefs about algorithms shape (offline) success in online dating: A two-wave longitudinal investigation[J]. Communication Research, 2021, 48(7): 931–952. |

| [44] | Shin D. The effects of explainability and causability on perception, trust, and acceptance: Implications for explainable AI[J]. International Journal of Human-Computer Studies, 2021, 146: 102551. |

| [45] | Shin D. How do people judge the credibility of algorithmic sources?[J]. AI & SOCIETY, 2022, 37(1): 81–96. |

| [46] | Shin D, Rasul A, Fotiadis A. Why am I seeing this? Deconstructing algorithm literacy through the lens of users[J]. Internet Research, 2022, 32(4): 1214–1234. |

| [47] | Siles I, Segura-Castillo A, Solís R, et al. Folk theories of algorithmic recommendations on Spotify: Enacting data assemblages in the global South[J]. Big Data & Society, 2020, 7(1), doi: 10.1177/2053951720923377. |

| [48] | Van Dijck J, Poell T, de Waal M. The platform society[M]. Oxford University Press, 2018. |

| [49] | Velkova J, Kaun A. Algorithmic resistance: Media practices and the politics of repair[J]. Information, Communication & Society, 2021, 24(4): 523–540. |

| [50] | Xie X Z, Du Y, Bai Q Y. Why do people resist algorithms? From the perspective of short video usage motivations[J]. Frontiers in Psychology, 2022, 13: 941640. |

| [51] | Zarouali B, Boerman S C, de Vreese C H. Is this recommended by an algorithm? The development and validation of the algorithmic media content awareness scale (AMCA-scale)[J]. Telematics and Informatics, 2021, 62: 101607. |